Whistleblowing e intelligenza artificiale: guida per RPCT e compliance manager sui nuovi rischi AI

L’introduzione massiccia dell’intelligenza artificiale nei processi decisionali delle organizzazioni pubbliche e private è già realtà: banche, assicurazioni, sanità, HR, Pubbliche Amministrazioni e infrastrutture critiche utilizzano da tempo sistemi automatizzati per valutare crediti, selezionare candidati, supportare diagnosi, automatizzare graduatorie e molto altro.

Finché tutto procede senza intoppi, è facile notare i benefici dell’AI in termini di efficientamento. Ma quando qualcosa va storto – bias, discriminazioni, uso scorretto dei dati – l’unico modo per far emergere il problema è spesso una segnalazione interna.

Ed è qui che nasce una domanda fondamentale per chi gestisce un canale whistleblowing:

Come utilizzare intercettare e gestire segnalazioni complesse su violazioni legate all’AI, proteggendo il segnalante e garantendo conformità normativa?

Per rispondere, dobbiamo guardare a dove l’AI genera rischi, cosa dice la normativa italiana e perché serve un approccio diverso.

Dove e come l’AI è già impiegata e quali segnalazioni di illeciti genera

È evidente che i rischi elencati non si configurano come illeciti “classici”, ma sono piuttosto anomalie tecniche con impatti legali, reputazionali e sociali che possono emergere soltanto grazie al riscontro di chi lavora con questi sistemi, sa leggere il codice o nota pattern ricorrenti negli output.

Inoltre le segnalazioni relative all’AI possono rivelarsi più complesse sia da interpretare (RPCT e responsabili compliance non sempre hanno conoscenze tecniche approfondite) sia da investigare, rendendo necessaria la collaborazione di figure esperte.

Normativa su AI e whistleblowing: basi legali e possibili evoluzioni

Italia e Unione Europea: quadro normativo

La Direttiva UE 2019/1937 e il D.Lgs. 24/2023 proteggono già chi segnala violazioni in materia di privacy, sicurezza informatica, discriminazioni, gestione illecita dei dati e rischi per l’interesse pubblico. L’AI ricade perfettamente in queste categorie.

A questo quadro normativo si aggiunge l’AI Act, recepito in Italia con la Legge n. 132 del 23 settembre 2025 (in vigore dal 20 ottobre 2025), che per i sistemi ad “alto rischio” introduce obblighi precisi:

Il vuoto legislativo sui “rischi futuri” dell’AI – destinato a chiudersi

Resta ancora scoperta la tutela esplicita per chi segnala rischi futuri: potenziali pregiudizi, vulnerabilità non ancora sfruttate, scenari di danno sistemico basati su ragionevole preoccupazione più che su prove certe.

Negli Stati Uniti e in California sono in corso di approvazione normative specifiche per proteggere i whistleblower AI, con tutele anche per segnalazioni basate su sospetti fondati e obblighi per i grandi sviluppatori di istituire canali interni dedicati.

L’Europa seguirà. Chi si attrezza fin da ora con canali adeguati, policy chiare e procedure specifiche sarà più preparato a evitare sanzioni, contenziosi e danni reputazionali.

I rischi AI che nessun audit di compliance tradizionale intercetta

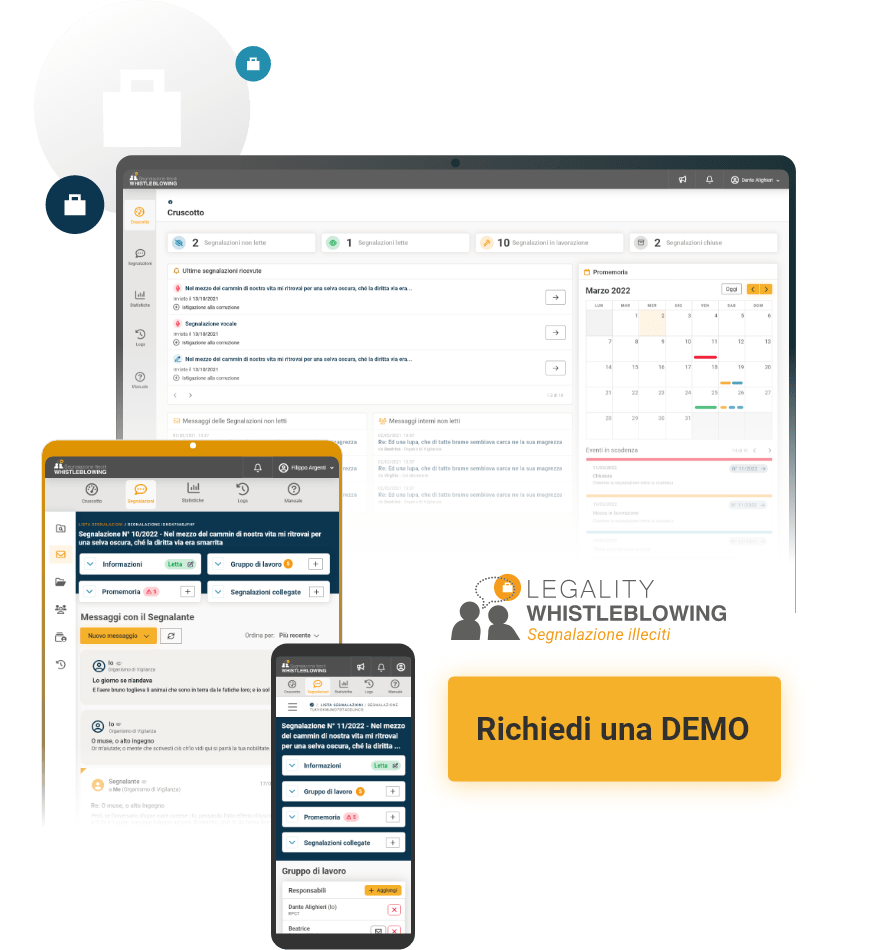

Come Legality Whistleblowing integra l’AI in modo sicuro

Il punto non è evitare l’AI, ma usarla nel modo giusto: controllata, interna, senza esporre dati sensibili.

Ed è così che funziona Legality Whistleblowing.

La piattaforma utilizza l’intelligenza artificiale solo in modo controllato, interno e coerente con le garanzie richieste dal D.Lgs. 24/2023. Questo permette di ottenere benefici operativi senza esporre l’identità del segnalante o i contenuti sensibili.

Ecco come si traduce nella pratica: